Pelatihan dan Sertifikasi BNSP – Dalam dunia data science, data merupakan aset berharga yang dapat menghasilkan insight bisnis, memprediksi tren, dan mendukung keputusan strategis. Data yang tidak terkelola dengan baik sering kali mengandung kesalahan atau ketidaksesuaian yang bisa menghambat analisis. Karena itu, proses data cleaning dan data preprocessing sangat penting untuk menjaga kualitas data. Artikel ini membahas pentingnya pengelolaan data, konsep data cleaning, macam-macam preprocessing, serta tahapan utama dalam membersihkan dan mempersiapkan data.

Seberapa Penting Pengelolaan Data dalam Data Science?

Pengelolaan data adalah fondasi bagi setiap proyek data science, karena keputusan yang diambil sangat bergantung pada kualitas data yang digunakan. Konsep “garbage in, garbage out” sangat relevan dalam konteks ini. Jika data yang diolah buruk, tidak akurat, atau tidak relevan, maka hasil analisis akan menyesatkan. Karena itu, data science membutuhkan data yang akurat, lengkap, dan konsisten agar setiap model atau analisis dapat diandalkan.

Dalam proses pengambilan keputusan berbasis data, kualitas data memegang peranan penting untuk menghasilkan insight yang tepat. Ketika data tidak dikelola dengan baik, model analisis atau prediksi yang dihasilkan bisa menjadi bias. Hal ini berisiko memunculkan rekomendasi yang salah. Sebagai contoh, dalam analisis pasar, data yang tidak tepat dapat menimbulkan kesimpulan yang menyarankan tren yang tidak relevan atau bahkan keliru. Hal ini berpotensi menimbulkan kerugian besar bagi bisnis, baik dalam aspek keuangan, sumber daya, maupun kepercayaan pelanggan. Inilah alasan mengapa pengelolaan data adalah langkah pertama dan paling krusial dalam proyek data science.

Lebih jauh, data yang berkualitas tidak hanya menghasilkan analisis yang andal. Data semacam ini juga membantu meminimalkan bias yang muncul akibat data yang tidak representatif. Misalnya, data dengan banyak nilai kosong, outlier, atau duplikat dapat membuat model kesulitan menangkap pola yang sebenarnya. Data yang tidak dikelola dengan baik bisa jadi mengarahkan pada interpretasi yang keliru, yang berdampak buruk pada keputusan strategis bisnis.

Proses pengelolaan data dalam data science mencakup beberapa langkah kritis, yaitu:

1. Identifikasi dan Penyaringan Data yang Relevan

Proses ini bertujuan untuk menentukan data mana yang benar-benar relevan untuk tujuan analisis. Tidak semua data yang tersedia perlu diolah; penyaringan data yang tidak relevan membantu mengurangi beban pemrosesan dan meningkatkan akurasi analisis. Identifikasi data yang tepat memiliki peran penting karena dengan semakin banyaknya data yang tersedia, data scientist perlu memilih informasi yang relevan agar model yang dibangun tidak menjadi terlalu kompleks atau berukuran terlalu besar.

2. Pembersihan Data (Data Cleaning)

Proses ini melibatkan penghapusan atau penanganan nilai yang hilang, duplikasi, dan inkonsistensi data. Pembersihan data memastikan bahwa data yang akan diolah bebas dari kesalahan yang dapat memengaruhi hasil analisis. Data yang telah melalui tahap pembersihan akan memiliki kualitas yang lebih baik sehingga model dapat bekerja dengan lebih optimal.

3. Transformasi Data

Transformasi data berfungsi untuk mengubah data mentah menjadi bentuk yang lebih sesuai dengan kebutuhan model analisis. Proses ini dapat meliputi normalisasi, standarisasi, maupun pengkategorian ulang. Dengan adanya tahap transformasi, data akan memiliki format dan struktur yang seragam sehingga lebih mudah diolah oleh algoritma.

4. Validasi Data

Setelah data diolah, penting untuk melakukan validasi guna memastikan bahwa data yang telah diproses benar-benar dapat diandalkan. Validasi data membantu mengidentifikasi anomali atau kesalahan yang mungkin masih tersisa dalam data dan memastikan bahwa data tersebut sudah memenuhi standar yang diinginkan.

Dalam dunia yang semakin bergantung pada data, pengelolaan data menjadi hal yang tidak dapat diabaikan. Data yang bersih adalah kunci utama untuk pengambilan keputusan yang tepat dan strategis. Dengan pengelolaan yang baik, organisasi dapat meningkatkan daya saing, memahami kebutuhan pelanggan, serta merespons perubahan pasar dengan cepat. Sebaliknya, tanpa pengelolaan yang memadai, organisasi berisiko mengambil keputusan berdasarkan informasi yang salah atau tidak akurat, yang dapat berdampak fatal pada keberlangsungan bisnis.

Di era digital ini, pengelolaan data yang diikuti pelatihan berkualitas tinggi merupakan investasi penting bagi keberhasilan setiap proyek data science. Ini adalah langkah awal untuk memastikan bahwa setiap tahap selanjutnya dalam proses analisis akan memberikan hasil yang bermakna, mendukung inovasi, dan mengarahkan organisasi menuju keberhasilan yang berkelanjutan.

Apa Itu Data Cleaning?

Data cleaning, atau pembersihan data, adalah langkah krusial dalam proses data science yang bertujuan untuk memastikan kualitas dan kebersihan data sebelum data tersebut digunakan dalam analisis atau pemodelan. Data yang bersih adalah fondasi bagi hasil analisis yang akurat dan andal. Proses ini melibatkan identifikasi dan perbaikan berbagai masalah umum dalam dataset, seperti nilai yang hilang (missing values), entri duplikat, nilai ekstrem (outliers), serta inkonsistensi dalam format atau struktur data.

Pentingnya data cleaning tidak bisa diremehkan. Tanpa data yang bersih, analisis atau model prediksi yang dibangun akan cenderung memberikan hasil yang salah atau menyesatkan. Misalnya, dalam kasus analisis penjualan, data yang memiliki entri duplikat atau format tanggal yang tidak konsisten akan mengaburkan pemahaman tentang performa penjualan. Demikian juga, dalam analisis kesehatan, data yang hilang atau tidak akurat bisa menyebabkan interpretasi yang salah mengenai tren kesehatan pasien atau prediksi risiko penyakit.

Proses data cleaning tidak hanya membersihkan data dari “sampah” atau data tidak relevan tetapi juga meningkatkan kualitas data secara keseluruhan. Berikut adalah beberapa metode yang umum digunakan dalam proses data cleaning:

1. Menghapus Nilai Duplikat

Duplikasi data terjadi ketika entri yang sama dimasukkan lebih dari sekali dalam dataset. Ini dapat menyebabkan bias dalam analisis, terutama ketika menghitung metrik agregat seperti rata-rata atau total. Penghapusan duplikasi sangat penting untuk memastikan bahwa setiap entri hanya dihitung satu kali dan tidak mengaburkan hasil analisis.

2. Menangani Nilai yang Hilang (Missing Values)

Nilai yang hilang merupakan masalah umum yang muncul karena berbagai alasan, misalnya kesalahan saat pengumpulan atau hilangnya data dalam proses pemrosesan. Beberapa metode dapat digunakan untuk menanganinya, antara lain deletion (menghapus entri yang hilang) dan imputation (mengisi data yang kosong). Pada metode imputation, nilai yang hilang diganti dengan angka tertentu, seperti rata-rata atau median kolom terkait, atau dengan prediksi yang dihasilkan berdasarkan analisis konteks. Pemilihan metode penanganan bergantung pada jumlah dan signifikansi nilai yang hilang serta jenis data.

3. Menangani Nilai Ekstrem atau Outliers

Outliers adalah data yang berada jauh dari nilai rata-rata atau distribusi normal data lainnya. Misalnya, dalam data penjualan, jika rata-rata penjualan adalah 100 unit per hari, tetapi ada satu entri dengan 1000 unit, ini bisa dianggap sebagai outlier. Outliers dapat memberikan pengaruh yang tidak proporsional terhadap model statistik atau algoritma pembelajaran mesin, sehingga sering kali perlu dihapus atau ditangani secara khusus. Namun, dalam beberapa kasus, outliers mungkin memiliki makna penting, sehingga perlu dianalisis lebih lanjut sebelum dihapus.

4. Standarisasi Format Data

Format data yang tidak konsisten bisa membingungkan proses analisis, terutama ketika data dikumpulkan dari berbagai sumber. Misalnya, tanggal mungkin ditulis dalam format berbeda (seperti DD/MM/YYYY atau MM-DD-YYYY), atau mata uang mungkin muncul dalam simbol berbeda. Dalam data cleaning, standarisasi format data adalah langkah penting untuk memastikan konsistensi dalam analisis dan pemrosesan data.

5. Validasi Kualitas Data

Validasi kualitas data adalah proses memeriksa apakah data yang akan digunakan memenuhi standar tertentu. Ini termasuk pengecekan apakah nilai dalam dataset berada dalam rentang yang sesuai atau apakah data telah melalui proses validasi yang memadai. Validasi ini membantu mengidentifikasi kesalahan yang mungkin luput dalam langkah-langkah sebelumnya dan memastikan bahwa data siap untuk analisis lebih lanjut.

6. Filtering Data

Filtering atau penyaringan data adalah teknik untuk menghapus data yang tidak relevan atau tidak sesuai dengan konteks analisis. Penyaringan dapat membantu mempercepat proses analisis dan fokus pada data yang benar-benar penting. Misalnya, dalam analisis perilaku konsumen, data yang dikumpulkan dari wilayah yang berbeda mungkin perlu difilter berdasarkan lokasi tertentu yang relevan dengan tujuan analisis.

Setiap langkah dalam data cleaning bertujuan untuk mengatasi berbagai tantangan dan meningkatkan kualitas data yang akan digunakan. Selain memastikan akurasi, proses data cleaning juga membantu mencegah bias dalam analisis dan memungkinkan data scientist untuk bekerja dengan data yang dapat dipercaya. Dengan data yang bersih, tim data science dapat mengembangkan model yang lebih akurat dan membuat keputusan yang lebih baik.

Lebih jauh, data cleaning juga mempengaruhi efisiensi model yang dikembangkan. Data yang mengandung kesalahan atau bias akan menyebabkan model bekerja secara tidak efisien, membutuhkan lebih banyak waktu komputasi, dan hasil akhirnya pun tidak akan maksimal. Oleh karena itu, data cleaning bukan hanya tahap persiapan tetapi merupakan bagian integral dari keseluruhan proyek data science yang berperan penting dalam keberhasilan proyek.

Dengan proses data cleaning yang menyeluruh memberikan data scientist landasan yang kuat untuk melanjutkan ke tahap analisis dan pemrosesan berikutnya. Data yang bersih dan akurat menjadi kunci dalam menghasilkan wawasan yang berharga dan dapat diandalkan bagi bisnis, pemerintah, maupun organisasi lain dalam pengambilan keputusan strategis.

Kenali Data Pra-Pemrosesan dan Macamnya

Pra-pemrosesan data, atau data pre-processing, adalah serangkaian langkah untuk mengubah data mentah menjadi format yang sesuai untuk diolah dalam analisis data atau pembuatan model data science. Data mentah, yang sering kali belum terstruktur atau mengandung banyak ketidaksesuaian, perlu disiapkan agar analisis yang dilakukan tidak hanya efisien tetapi juga menghasilkan wawasan yang akurat. Tahapan pra-pemrosesan ini membantu menata, membersihkan, dan menyesuaikan data sehingga bisa memberikan hasil yang lebih mendalam dan relevan.

Dalam data science, pre-processing sangatlah penting karena model atau algoritma yang digunakan untuk analisis sering kali memerlukan data dalam bentuk tertentu. Tanpa pre-processing, model bisa saja menghasilkan kesimpulan yang bias atau bahkan tidak akurat karena ketidaksesuaian data. Berikut adalah beberapa teknik utama yang biasa digunakan dalam pra-pemrosesan data:

1. Normalisasi

Normalisasi adalah teknik yang bertujuan untuk menskalakan data numerik agar berada dalam rentang seragam, misalnya antara 0 dan 1. Penerapan metode ini sangat penting terutama pada model yang sensitif terhadap skala data, seperti algoritma pembelajaran mesin berbasis jarak, karena perbedaan skala dapat menimbulkan bias. Dengan adanya normalisasi, data menjadi lebih konsisten sehingga memudahkan model dalam membandingkan atribut yang berbeda secara proporsional.

2. Standarisasi

Standarisasi mengubah data agar memiliki rata-rata 0 dan standar deviasi 1, yang ideal untuk data dengan distribusi normal. Teknik ini membantu model lebih mudah memahami pola dalam data yang tersebar secara simetris, terutama dalam algoritma statistik atau pembelajaran mesin yang mengandalkan asumsi distribusi normal. Dengan standarisasi, model dapat memproses data lebih akurat tanpa adanya bias akibat skala yang beragam.

3. Encoding

Encoding adalah teknik untuk mengonversi data kategori, seperti jenis kelamin atau status pernikahan, menjadi format numerik agar dapat digunakan dalam model pembelajaran mesin. Model algoritma cenderung bekerja dengan angka, sehingga data kategori perlu dikonversi ke dalam bentuk numerik, misalnya dengan one-hot encoding untuk kategori yang memiliki beberapa opsi, atau menggunakan skema 0 dan 1 untuk data biner seperti “Ya” dan “Tidak.”

4. Feature Extraction

Feature extraction, atau ekstraksi fitur, adalah proses untuk menentukan fitur-fitur yang paling relevan dalam sebuah dataset dan mengurangi dimensi data tanpa menghilangkan informasi penting. Teknik ini sangat berguna untuk dataset yang besar dan kompleks, seperti data gambar atau teks, di mana terdapat banyak atribut yang mungkin tidak semuanya relevan untuk analisis tertentu. Ekstraksi fitur membantu mengurangi beban komputasi model, menjadikannya lebih efisien tanpa kehilangan nilai informatif.

5. Data Scaling

Data scaling adalah teknik untuk menyesuaikan skala data agar berada dalam rentang yang sama, terutama penting dalam model berbasis gradient descent. Scaling membantu model memperlakukan semua variabel secara setara tanpa menganggap variabel dengan skala lebih besar lebih signifikan, sehingga menghasilkan hasil yang lebih stabil.

Dengan melakukan pra-pemrosesan, data menjadi lebih mudah dikelola dan sesuai dengan kebutuhan analisis. Setiap teknik di atas bertujuan untuk mengatasi masalah data yang tidak terstruktur atau tidak konsisten, sehingga analisis atau model yang dihasilkan bisa berjalan secara optimal.

Fungsi dari Data Pra-Pemrosesan

Data pra-pemrosesan adalah langkah krusial dalam data science, yang memungkinkan data mentah diubah menjadi format yang lebih bersih, terstruktur, dan siap untuk dianalisis secara efektif. Dengan mempersiapkan data sebelum dianalisis atau digunakan dalam model machine learning, pra-pemrosesan membantu mengurangi kompleksitas dan memungkinkan model memfokuskan analisis pada pola atau tren yang penting, tanpa terganggu oleh kesalahan atau ketidakteraturan data. Setiap langkah pra-pemrosesan bertujuan untuk meningkatkan kualitas data sehingga hasil analisis menjadi lebih akurat, relevan, dan dapat dipercaya.

AMD Academy memberikan pengetahuan dan pelatihan mendalam tentang fungsi utama pra-pemrosesan data, yang menjadi landasan penting dalam setiap proyek data science.

1. Meningkatkan Efisiensi Model

Pra-pemrosesan membuat data lebih seragam dan terstruktur, yang pada gilirannya membantu model bekerja lebih cepat dan efisien. Sebagai contoh, dalam model pembelajaran mesin, data yang terstruktur dan telah melalui proses normalisasi atau standarisasi akan mempercepat konvergensi model, karena model tidak perlu menyesuaikan untuk perbedaan skala atau format data yang besar. Dengan data yang sudah terstruktur, model dapat menyerap informasi lebih cepat dan mengurangi waktu pelatihan. Efisiensi ini juga membantu menghemat sumber daya komputasi, terutama dalam proyek-proyek yang melibatkan dataset besar.

2. Mengurangi Bias

Data yang tidak diproses cenderung mengandung bias atau ketidakkonsistenan yang dapat memengaruhi hasil analisis. Bias ini bisa berasal dari data yang tidak lengkap, entri yang berulang, atau representasi yang tidak seimbang. Pra-pemrosesan membantu menghilangkan atau setidaknya mengurangi bias tersebut dengan membersihkan data, mengisi nilai yang hilang, dan menghapus duplikat. Dengan demikian, model dapat belajar dari data yang lebih representatif dan menghasilkan kesimpulan yang lebih objektif. Ini sangat penting untuk menjaga validitas hasil analisis, terutama dalam aplikasi yang berisiko tinggi seperti analisis medis atau prediksi keuangan.

3. Memudahkan Interpretasi Hasil

Model machine learning dan data science sering kali menghasilkan hasil yang rumit atau sulit diinterpretasikan. Data yang telah melalui tahap pra-pemrosesan lebih mudah dipahami karena telah distandarisasi dan disederhanakan, memungkinkan model memberikan hasil yang lebih jelas dan relevan. Misalnya, dalam analisis perilaku konsumen, data kategori yang telah diencode dan data numerik yang sudah dinormalisasi memudahkan model untuk memberikan segmentasi yang lebih akurat dan mudah diinterpretasikan oleh pengguna. Dengan data yang telah diproses, hasil model tidak hanya lebih akurat tetapi juga lebih bermakna bagi pengguna akhir.

4. Mengurangi Kesalahan dan Ketidakkonsistenan dalam Data

Pra-pemrosesan juga mengurangi kesalahan dalam data yang mungkin timbul dari input manual atau sumber yang beragam. Misalnya, data yang diperoleh dari berbagai departemen dalam perusahaan bisa memiliki format yang berbeda atau mengandung entri yang bertentangan. Proses pra-pemrosesan mengidentifikasi dan menyelaraskan perbedaan ini sehingga data yang dihasilkan lebih konsisten dan siap digunakan. Hal ini membantu model meminimalkan kesalahan prediksi yang bisa muncul akibat data yang tidak terintegrasi dengan baik.

5. Mengoptimalkan Penggunaan Data

Dengan pra-pemrosesan, data yang awalnya tampak tidak berstruktur atau tidak lengkap dapat dioptimalkan sehingga lebih banyak informasi yang bisa dimanfaatkan dalam analisis. Tahap seperti data cleaning dan data integration memungkinkan data yang awalnya memiliki banyak kekurangan untuk diubah menjadi data yang lebih bernilai. Hal ini sangat berguna ketika bekerja dengan dataset yang terbatas, di mana setiap informasi berharga bisa berpengaruh besar terhadap hasil akhir analisis.

6. Memastikan Data Sesuai dengan Persyaratan Mode

Banyak algoritma machine learning memiliki persyaratan tertentu terhadap data yang digunakan, seperti bentuk data, skala, atau distribusi. Pra-pemrosesan membantu memastikan data memenuhi persyaratan tersebut sehingga dapat digunakan tanpa hambatan dalam berbagai algoritma atau model. Misalnya, algoritma berbasis jarak, seperti K-Nearest Neighbors, memerlukan data dalam skala yang sama untuk memberikan hasil yang optimal. Melalui pra-pemrosesan, data disiapkan agar sesuai dengan setiap model yang diterapkan, sehingga hasil yang diperoleh lebih akurat.

Dengan menjalankan pra-pemrosesan, data mentah diubah menjadi lebih rapi, konsisten, dan siap pakai. Proses ini juga mengurangi kompleksitas data dan memungkinkan model mengidentifikasi pola atau hubungan yang sebenarnya ada dalam data, menghasilkan wawasan yang lebih akurat dan relevan. Pra-pemrosesan bukan hanya tentang membersihkan data, tetapi juga tentang memastikan bahwa data dapat memberikan nilai maksimal untuk setiap analisis yang dilakukan.

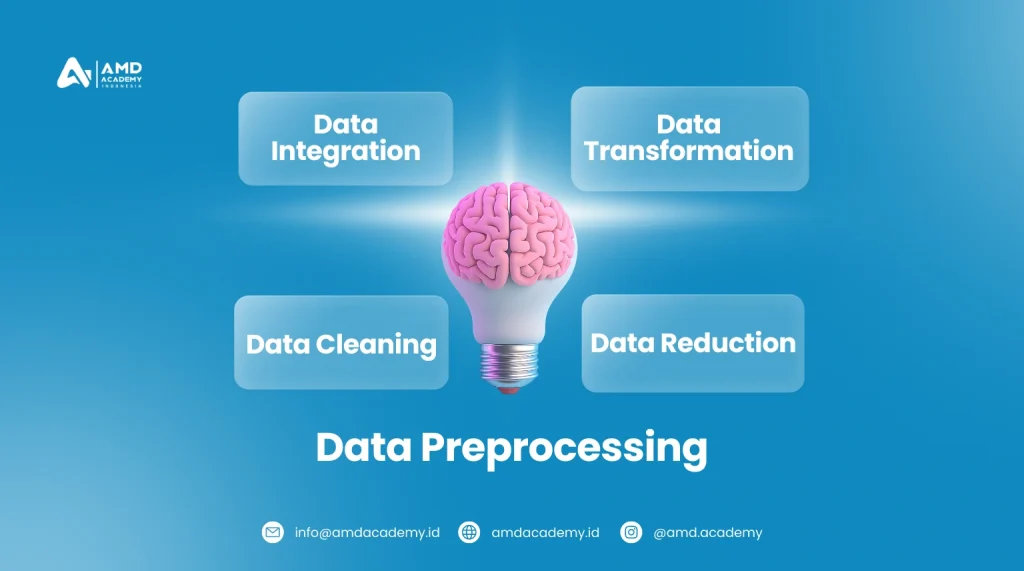

Tahapan dalam Pre-Processing

Pra-pemrosesan data bukanlah proses satu langkah, melainkan serangkaian tahapan yang dilakukan secara sistematis untuk memastikan data siap digunakan. Berikut adalah tahapan yang umumnya dilakukan dalam pre-processing:

1. Data Cleaning

Tahap pertama adalah data cleaning, yang bertujuan untuk membersihkan data dari berbagai masalah seperti data yang hilang, duplikat, atau inkonsistensi. Data yang tidak lengkap atau tidak relevan dihilangkan untuk menghindari kesalahan dalam analisis. Misalnya, data kosong pada kolom penting bisa diisi dengan rata-rata atau nilai median agar analisis tetap representatif, sementara data duplikat bisa dihapus agar tidak menyebabkan bias dalam perhitungan statistik.

2. Data Integration

Ketika data berasal dari berbagai sumber, data integration bertujuan untuk menyatukan data tersebut ke dalam satu dataset yang seragam. Pada tahap ini, format data dari berbagai sumber disesuaikan agar kompatibel. Contohnya, data yang dikumpulkan dari berbagai divisi dalam perusahaan sering kali memiliki format atau skema yang berbeda; data integration menyatukan format tersebut sehingga data dapat diolah dengan mudah.

3. Transformasi Data

Setelah data digabungkan, langkah selanjutnya adalah transformasi data, yang mencakup pengubahan atau penyelarasan data ke dalam format tertentu agar mudah diproses. Transformasi ini meliputi encoding data kategori, normalisasi, standarisasi, serta perubahan lain yang disesuaikan dengan jenis analisis yang akan dilakukan. Misalnya, data tanggal mungkin perlu diubah menjadi format standar, sementara data kategori bisa diencode agar model dapat memahami dan menggunakannya dalam analisis.

4. Data Reduction

Tahap terakhir dalam pra-pemrosesan adalah data reduction atau pengurangan data. Tujuan dari tahap ini adalah untuk mengurangi kompleksitas dataset, terutama saat dataset terlalu besar. Teknik data reduction mencakup dimensionality reduction (pengurangan dimensi) untuk menyederhanakan jumlah fitur tanpa kehilangan informasi, numerosity reduction untuk mengurangi jumlah data sambil mempertahankan pola utama, dan data compression untuk mengompres dataset sehingga lebih efisien dalam penyimpanan dan pemrosesan.

Pra-pemrosesan data berfungsi sebagai fondasi bagi proses analisis atau pembuatan model berikutnya. Dengan melewati tahapan ini, data menjadi lebih berkualitas dan siap untuk diolah, memungkinkan model untuk memahami pola dengan lebih mudah dan menghasilkan wawasan yang relevan serta akurat. Pra-pemrosesan yang baik adalah kunci untuk kesuksesan dalam setiap proyek data science.

Step by Step Data Cleaning dan Data Preprocessing

Data cleaning dan data preprocessing adalah dua tahapan krusial dalam data science untuk memastikan bahwa data yang diolah relevan, akurat, dan berkualitas tinggi. Melalui pelatihan data science, langkah-langkah ini dipelajari untuk mengoptimalkan dataset agar lebih siap digunakan dalam analisis dan pemodelan. Proses tersebut membuat data menjadi lebih terstruktur dan bebas dari noise yang dapat mengganggu hasil analisis. Berikut adalah penjelasan rinci mengenai tahapan utama dalam data cleaning dan preprocessing.

1. Pemahaman Data (Data Understanding)

Pemahaman data adalah tahap pertama di mana seorang data scientist atau analyst perlu memahami konteks dan karakteristik dataset yang akan digunakan. Ini melibatkan eksplorasi setiap variabel, format data, serta pola yang mungkin muncul. Dengan memahami pola umum dan distribusi dalam data, akan lebih mudah untuk mengidentifikasi data yang abnormal, seperti data yang hilang atau tidak sesuai. Langkah ini meliputi analisis distribusi setiap kolom, perhitungan statistik deskriptif (seperti rata-rata, median, dan deviasi standar), serta identifikasi tren atau pola yang bisa memengaruhi langkah berikutnya dalam proses pembersihan data.

2. Identifikasi dan Penanganan Duplikat

Duplikat data sering kali muncul ketika data dikumpulkan dari berbagai sumber atau diimpor berulang kali tanpa pembersihan. Duplikasi dapat menyebabkan overestimasi dalam analisis dan menyebabkan bias. Identifikasi duplikat biasanya dilakukan dengan memeriksa data pada baris yang identik, kemudian dihapus jika tidak menambah nilai informasi. Misalnya, jika sebuah entri muncul dua kali dalam dataset penjualan produk, hal itu bisa menyebabkan perhitungan penjualan produk tertentu menjadi lebih tinggi dari yang seharusnya.

3. Penanganan Nilai Hilang (Missing Values)

Data yang hilang merupakan tantangan umum dalam data science. Ada beberapa pendekatan untuk menangani missing values, tergantung pada konteks dan proporsi nilai yang hilang. Metode imputasi, seperti pengisian nilai hilang dengan mean atau median, sering digunakan untuk menjaga keutuhan data. Di sisi lain, jika kolom atau baris memiliki banyak nilai hilang, mungkin lebih baik untuk menghapusnya seluruhnya, karena pengisian dapat menimbulkan bias jika data yang hilang terlalu banyak. Beberapa metode canggih, seperti k-Nearest Neighbors Imputation atau Multiple Imputation, dapat digunakan pada dataset dengan pola missing values yang kompleks untuk meningkatkan akurasi dalam analisis.

4. Transformasi Data

Transformasi data adalah proses mengubah data ke format atau tipe yang sesuai untuk analisis selanjutnya. Ini bisa melibatkan konversi data kategori menjadi numerik melalui encoding, seperti one-hot encoding untuk kolom yang memiliki lebih dari dua kategori. Transformasi juga termasuk konversi tipe data (seperti mengubah string menjadi datetime untuk kolom tanggal) dan pembuatan variabel baru dari variabel yang ada untuk memberikan informasi tambahan. Misalnya, variabel tanggal_lahir dapat diubah menjadi usia jika yang lebih relevan untuk analisis adalah usia individu tersebut.

5. Normalisasi dan Standarisasi Data

Normalisasi serta standarisasi berfungsi untuk mengubah data numerik menjadi format yang lebih homogen, khususnya ketika model analisis atau machine learning membutuhkan data dengan skala seragam. Dalam praktiknya, normalisasi mengatur nilai ke dalam rentang tertentu, umumnya antara 0 sampai 1, sehingga data dengan skala berbeda dapat dibandingkan secara proporsional. Standarisasi, di sisi lain, mengubah data agar memiliki rata-rata nol dan deviasi standar satu. Teknik ini terutama penting dalam model statistik yang berbasis jarak atau saat fitur memiliki distribusi yang seragam.

6. Deteksi dan Penghapusan Outlier

Outlier adalah data yang berada jauh dari rentang normal dan dapat secara signifikan memengaruhi hasil analisis atau model machine learning. Outlier biasanya dideteksi dengan metode statistik, seperti z-score atau Interquartile Range (IQR), yang membantu menemukan data yang berada di luar kisaran yang diharapkan. Dalam beberapa kasus, outlier dapat menunjukkan kesalahan data, sehingga harus dihapus; namun, dalam situasi lain, outlier bisa menjadi data penting (misalnya, peningkatan penjualan yang luar biasa). Penting untuk menilai apakah outlier sebaiknya dihapus, dikurangi pengaruhnya, atau dipertahankan tergantung konteks analisis.

7. Pembersihan Data Teks (Text Cleaning)

Jika data berupa teks, tahapan pembersihan mencakup menghapus karakter tidak relevan, menormalisasi ejaan atau case (seperti mengubah semua teks menjadi lowercase), dan menghapus kata-kata umum yang tidak membawa informasi (stopwords). Pembersihan teks juga dapat mencakup lemmatization atau stemming, yang mengubah kata ke bentuk dasarnya. Langkah-langkah ini memastikan data teks lebih mudah diinterpretasi oleh model NLP atau analisis teks yang akan dilakukan, mengurangi noise, dan meningkatkan kualitas output.

8. Penggabungan Data (Data Merging)

Tahap ini melibatkan penggabungan dataset dari berbagai sumber untuk mendapatkan dataset yang lebih informatif. Proses ini bisa dilakukan melalui operasi join atau merge pada variabel yang sama antar tabel. Misalnya, menggabungkan data penjualan dari berbagai cabang atau menghubungkan data pelanggan dengan transaksi. Teknik merging memungkinkan integrasi data secara efisien, namun penting untuk memastikan bahwa data memiliki format dan tipe yang konsisten di seluruh dataset.

Dengan mengikuti tahapan ini, proses data cleaning dan data preprocessing dapat membantu menghasilkan dataset yang berkualitas tinggi. Dataset yang telah melalui tahap ini tidak hanya lebih bersih tetapi juga siap untuk analisis lebih lanjut, baik dalam analisis statistik dasar maupun pemodelan machine learning yang kompleks.

Mengembangkan skill dalam pengelolaan data melalui pelatihan akan membuka banyak peluang dalam data science, mengingat pengelolaan data yang baik adalah dasar dari setiap model yang sukses.

Skill Apa Saja yang Dibutuhkan untuk Menguasai Pengelolaan Data

Menguasai pengelolaan data melalui pelatihan dalam bidang data science bukan hanya memerlukan keterampilan teknis, tetapi juga pemahaman mendalam tentang metode pembersihan dan pra-pemrosesan data. Untuk memperoleh keahlian ini, mengikuti pelatihan dan sertifikasi yang berfokus pada data science, seperti Pelatihan dan Sertifikasi BNSP Data Science dari AMD Academy, dapat sangat membantu. Sertifikasi BNSP ini mengakui keterampilan Anda secara nasional dan memberikan bekal teknik praktis serta teori yang diperlukan untuk memaksimalkan kualitas analisis data.

1. Pelajari Berbagai Teknik dan Algoritma Data Cleaning dan Pre-processing

Mengikuti program Pelatihan dan Sertifikasi BNSP Data Science, Anda akan mempelajari teknik-teknik dasar data cleaning, seperti identifikasi data hilang, pengisian nilai kosong, normalisasi, dan encoding. Anda juga akan mempelajari algoritma lanjutan yang mendukung proses otomatisasi pembersihan data, termasuk algoritma untuk imputasi data yang hilang dan deteksi outliers.

2. Latihan Menggunakan Berbagai Dataset

Berlatih dengan dataset yang bervariasi membantu memahami berbagai pola data dan tantangan di setiap sektor. Latihan ini dapat dilakukan melalui proyek mandiri, seperti analisis data keuangan, kesehatan, atau retail. Dalam Pelatihan dan Sertifikasi BNSP Data Science, Anda juga akan memiliki akses ke studi kasus nyata yang mempersiapkan Anda menghadapi masalah praktis.

3. Pelajari Alat dan Bahasa Pemrograman yang Mendukung

Dalam pelatihan ini, Anda akan belajar memanfaatkan alat-alat seperti Python, dengan pustaka Pandas dan NumPy, serta SQL untuk memproses data dalam jumlah besar. R juga dapat dipelajari untuk pengelolaan data yang spesifik dengan package seperti dplyr. Menguasai alat-alat ini meningkatkan efisiensi kerja, memungkinkan otomatisasi proses data cleaning, dan mempermudah visualisasi data.

4. Ikuti Pelatihan Profesional dan Terakreditasi

Pelatihan dan Sertifikasi BNSP Data Science dari AMD Academy memberikan kurikulum intensif yang mencakup teknik praktis pengelolaan data, mulai dari data wrangling hingga pembuatan model. Materi pelatihan mencakup dasar-dasar teknik pembersihan data, visualisasi data, hingga metode machine learning, yang relevan bagi berbagai sektor industri.

5. Bangun Proyek Pribadi dan Portofolio

Dalam pelatihan ini, Anda juga didorong untuk mengembangkan proyek mandiri yang dapat dijadikan sebagai portofolio, menunjukkan kemampuan nyata dalam pengelolaan data dan penyelesaian masalah yang kompleks. Portofolio proyek pada platform seperti GitHub adalah cara efektif untuk menarik perhatian perusahaan di bidang data science.

Dengan mengikuti Pelatihan dan Sertifikasi BNSP Data Science dari AMD Academy, Anda akan memperoleh keterampilan praktis, teori yang mendalam, dan pengakuan nasional atas kompetensi Anda dalam data science.

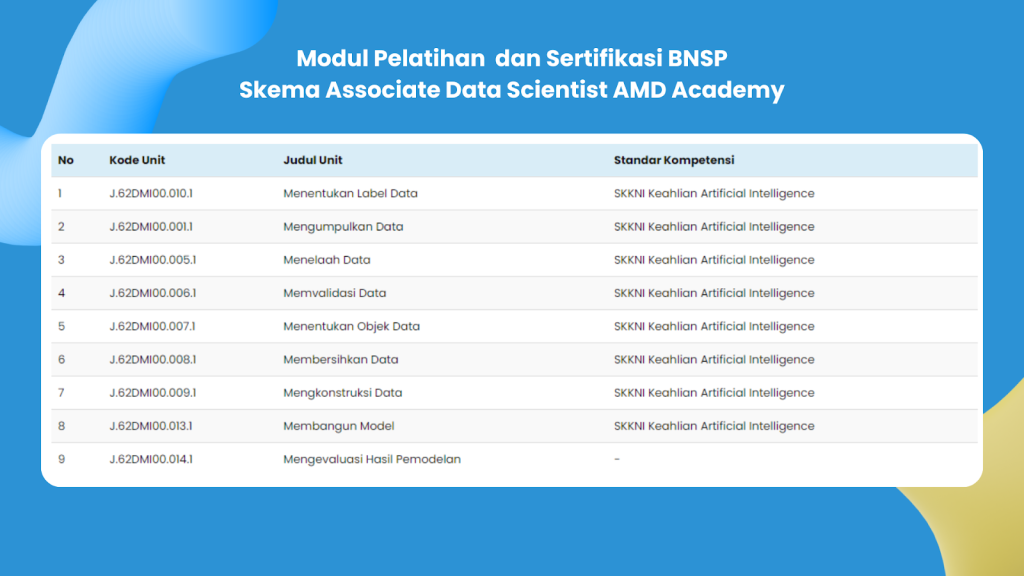

Modul Pelatihan Berstandar SKKNI dari AMD Academy

AMD Academy menyediakan program Pelatihan dan Sertifikasi BNSP yang berlandaskan SKKNI (Standar Kompetensi Kerja Nasional Indonesia). Program ini dirancang untuk membekali peserta dengan pengetahuan dan keterampilan praktis yang diperlukan dalam pengelolaan data melalui pelatihan data science. Setiap modul pelatihan dirancang untuk memberikan pemahaman yang mendalam tentang berbagai aspek pengolahan data, sehingga peserta dapat mempersiapkan diri dengan baik untuk memasuki dunia kerja yang kompetitif.

1. Menentukan Label Data

Dalam modul ini, peserta belajar cara menentukan label data yang tepat. Labeling yang efektif tidak hanya membantu dalam pengelompokan data, tetapi juga sangat penting dalam meningkatkan akurasi model. Teknik yang diajarkan mencakup penggunaan alat bantu dan algoritma untuk otomatisasi labeling, serta strategi manual untuk dataset kecil.

2. Mengumpulkan Data

Peserta akan mempelajari metode dan teknik pengumpulan data dari berbagai sumber, termasuk survei, database online, dan API. Penekanan akan diberikan pada pengumpulan data yang etis dan legal, serta pentingnya mengidentifikasi sumber data yang dapat dipercaya. Penggunaan alat seperti web scraping dan software survey juga akan dibahas.

3. Menelaah Data

Modul ini bertujuan untuk melatih peserta dalam menganalisis data secara awal. Peserta akan belajar cara menggunakan visualisasi data untuk mengidentifikasi pola, tren, dan anomali dalam dataset. Teknik statistik dasar juga akan diperkenalkan untuk memberikan gambaran lebih mendalam mengenai distribusi data.

4. Memvalidasi Data

Validasi data adalah langkah krusial untuk memastikan kualitas dan integritas data. Peserta akan belajar cara menerapkan teknik validasi, termasuk cross-validation dan pengujian hipotesis. Modul ini juga mencakup strategi untuk menangani data yang tidak konsisten atau cacat.

5. Menentukan Objek Data

Peserta diajarkan bagaimana memilih objek data yang relevan untuk analisis, serta cara merumuskan pertanyaan penelitian yang tepat. Modul ini bertujuan untuk meningkatkan kemampuan peserta dalam merumuskan hipotesis yang dapat diuji dan relevan dengan tujuan analisis.

6. Membersihkan Data

Pembersihan data adalah salah satu keterampilan terpenting dalam data science. Peserta akan mempelajari teknik-teknik canggih dalam data cleaning, termasuk penghapusan duplikat, pengisian nilai hilang menggunakan metode imputasi, dan penggunaan alat seperti Pandas di Python untuk melakukan pembersihan data secara efisien.

7. Mengkonstruksi Data

Dalam modul ini, peserta akan belajar bagaimana mengkonstruksi dataset yang siap untuk analisis. Ini termasuk teknik penggabungan data, transformasi, dan normalisasi. Peserta juga akan memahami pentingnya membuat dataset yang terstruktur dengan baik untuk memudahkan analisis selanjutnya.

8. Membangun Model

Peserta akan diperkenalkan pada berbagai algoritma pemodelan, mulai dari regresi hingga machine learning. Pelatihan ini memberikan kesempatan untuk menerapkan teori dalam praktik, termasuk penggunaan framework seperti TensorFlow dan Scikit-learn.

9. Mengevaluasi Hasil Pemodelan

Evaluasi model adalah langkah penting untuk menilai efektivitas pemodelan. Peserta akan mempelajari berbagai metrik evaluasi, termasuk akurasi, precision, recall, dan F1 score. Modul ini juga mencakup teknik untuk tuning hyperparameters dan melakukan validasi silang.

Melalui program Pelatihan dan Sertifikasi BNSP Data Science di AMD Academy, peserta akan memperoleh keterampilan yang diakui secara nasional dan siap untuk tantangan di dunia kerja. Dengan bergabung dalam program ini, Anda akan mendapatkan pemahaman yang mendalam serta praktik langsung yang diperlukan dalam bidang data science. Untuk informasi lebih lanjut dan pendaftaran, kunjungi AMD Academy dan ambil langkah pertama dalam karier data science Anda!

Tingkatkan Keahlian Anda dengan Sertifikasi Resmi

Keterampilan dalam membersihkan dan pra-pemrosesan data sangat esensial bagi setiap data scientist. Dengan Pelatihan dan Sertifikasi BNSP Data Scientist dari AMD Academy, Anda akan mendapatkan pelatihan yang menyeluruh dalam teknik pengelolaan data, baik secara teori maupun praktik. Program ini dirancang untuk memenuhi kebutuhan industri, memberikan Anda kompetensi yang diakui oleh BNSP, serta memberikan nilai tambah bagi karir Anda di bidang data science.

Jika Anda siap meningkatkan kemampuan dalam pengelolaan data dan menjadi data scientist yang andal, ikutilah Pelatihan dan Sertifikasi BNSP Data Scientist dari AMD Academy. Hubungi kami di sini!

Author: Sesario Kevin Putratama (DTS Batch 7)

Editor : Aulia Fathir Rizqi